O ecossistema da publicação científica está em profunda transformação. Ferramentas baseadas em aprendizado de máquina, como assistentes de escrita, detectores de plágio, tradutores automáticos e revisores gramaticais, tornaram-se partes integrantes do fluxo editorial.

No entanto, à medida que essas tecnologias ganham espaço e sofisticação, novos dilemas éticos e práticos precisam ser discutidos, especialmente no que diz respeito à segurança de dados, à autoria científica e à responsabilidade pela integridade da informação.

O que antes era um processo estritamente humano — revisão, edição e publicação — agora se encontra mediado por algoritmos capazes de influenciar decisões editoriais e até de gerar conteúdos inteiros.

Desde 2020, o uso de IA em plataformas acadêmicas se expandiu vertiginosamente. Editores e periódicos passaram a utilizar sistemas automáticos de triagem de manuscritos (como os softwares AI-powered desk review), que auxiliam na identificação de conformidade com escopo, qualidade linguística e até originalidade. Grandes editoras científicas já incorporam IA em etapas do fluxo editorial, otimizando o tempo de avaliação e aumentando a eficiência na detecção de problemas éticos.

Por outro lado, pesquisadores começaram a adotar ferramentas como ChatGPT, Claude, Scite, Grammarly e Paperpal para aprimorar a escrita científica, traduzir artigos e estruturar revisões de literatura. Em um cenário de crescente pressão por produtividade, essas soluções se tornaram indispensáveis.

Contudo, o uso indiscriminado de IA suscita questões fundamentais: até que ponto o texto gerado ou editado por algoritmos pode ser considerado produto intelectual humano? E, mais grave ainda, o que acontece com os dados e manuscritos sensíveis processados por esses sistemas?

Risco invisível

Os manuscritos científicos frequentemente contêm dados inéditos de pesquisas em andamento, informações pessoais de participantes de estudos clínicos e resultados que, se divulgados prematuramente, podem comprometer patentes ou causar danos à reputação de instituições. Ao submeter esses textos a sistemas de IA conectados à nuvem, pesquisadores podem, inadvertidamente, expor dados confidenciais a terceiros.

Em 2023, um caso emblemático envolveu uma universidade europeia que descobriu que trechos de um artigo inédito haviam sido indexados por um mecanismo público de busca após uso de uma ferramenta gratuita de correção baseada em IA. O episódio acendeu um alerta sobre a fragilidade das políticas de privacidade dessas plataformas e a falta de transparência quanto ao armazenamento e uso posterior das informações processadas.

Além disso, alguns modelos de linguagem são treinados com grandes volumes de textos extraídos da internet, incluindo artigos científicos e bases de dados sem autorização explícita. Esse aspecto levanta preocupações sobre violação de direitos autorais, consentimento e uso ético de dados acadêmicos em treinamentos de IA.

A dupla face da IA

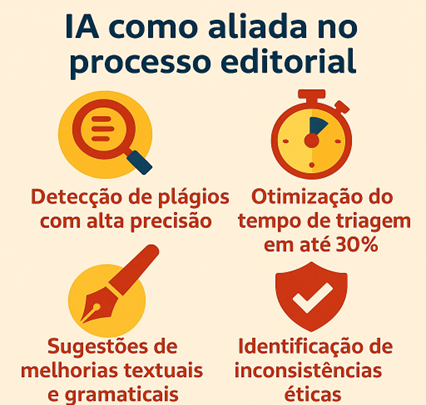

A IA é, indiscutivelmente, uma aliada poderosa. Ela permite identificar plágios com precisão, sugerir melhorias na clareza textual e até detectar manipulação de imagens ou dados — algo essencial para o combate às más condutas científicas. O Publisher Ethics Report (Cope, 2024) destaca que o uso de IA reduziu em até 30% o tempo médio de triagem de manuscritos em revistas de médio porte e aumentou a detecção de irregularidades éticas.

Entretanto, a mesma tecnologia pode ser usada de forma indevida. Em 2023, a Nature identificou uma série de artigos submetidos que apresentavam redação coerente, mas sem dados verificáveis — uma prática associada ao uso de IA generativa para criar pseudopesquisas ou “paper mills“. Esses casos desafiam os editores a desenvolver novos protocolos de verificação, capazes de distinguir entre textos gerados artificialmente e produções científicas autênticas.

Outro desafio é o viés algorítmico. Sistemas de IA podem reproduzir vieses existentes nas bases de dados de treinamento, levando à exclusão involuntária de estudos provenientes de regiões periféricas ou de áreas emergentes do conhecimento. Assim, a IA, se não for auditada, pode perpetuar desigualdades epistemológicas e reforçar a hegemonia de centros acadêmicos dominantes.

Responsabilidade compartilhada

Diante desse panorama, surge um novo código moral na ciência: quem é o verdadeiro autor em um texto produzido com auxílio da IA? O Comitê Internacional de Editores de Revistas Médicas (ICMJE) e a Cope já se pronunciaram oficialmente sobre o tema, afirmando que ferramentas de IA não podem ser creditadas como autoras, pois carecem de responsabilidade ética e legal. Entretanto, recomendam que os autores humanos declarem explicitamente qualquer uso de IA em suas submissões.

Essa transparência é essencial, pois permite aos editores avaliar o grau de intervenção algorítmica no conteúdo e assegurar que os resultados apresentados são fruto de trabalho científico verificável. O ocultamento do uso de IA, por sua vez, pode configurar má conduta, uma vez que altera a natureza do processo de autoria e compromete a rastreabilidade do conhecimento.

Outro aspecto ético emergente refere-se ao uso de IA para revisar ou selecionar artigos. Algoritmos podem priorizar textos com padrões linguísticos “ocidentais” ou com terminologias mais comuns em bases de dados de língua inglesa, marginalizando contribuições valiosas de pesquisadores de países em desenvolvimento. A automatização excessiva da triagem pode, assim, reduzir a diversidade epistêmica, comprometendo a pluralidade que sustenta a ciência global.

Mecanismos de governança

O desafio contemporâneo não está em conter o uso da IA, mas em instituir mecanismos de governança ética e segurança digital. Universidades, agências de fomento e editoras precisam adotar diretrizes claras sobre o uso dessas ferramentas, estabelecendo protocolos que garantam privacidade, consentimento e integridade.

Medidas práticas já começam a ser implementadas. Algumas revistas científicas exigem a declaração de ferramentas de IA utilizadas durante a escrita; outras, como Science e Nature, proíbem a inserção de textos gerados integralmente por IA. Plataformas de submissão estão sendo adaptadas para incluir termos de confidencialidade e criptografia de dados.

Além disso, pesquisadores são encorajados a utilizar versões institucionais ou locais de modelos de IA, hospedadas em servidores seguros, a fim de evitar a exposição de dados sensíveis. O desenvolvimento de sistemas de IA explicáveis também se mostra promissor, permitindo compreender como os algoritmos tomam decisões e aumentando a confiabilidade dos processos editoriais automatizados.

Entre o progresso e a prudência

O uso de inteligência artificial na publicação científica também impõe uma responsabilidade inédita à comunidade acadêmica. Proteger a segurança dos dados e preservar os princípios éticos da ciência são condições indispensáveis para que o avanço tecnológico não se converta em ameaça à credibilidade da produção científica.

Cabe aos pesquisadores, editores e instituições encontrar um equilíbrio entre progresso tecnológico e prudência ética, garantindo que a IA seja uma ferramenta de apoio — e não de substituição — ao pensamento crítico humano. Afinal, a ciência é, antes de tudo, um empreendimento coletivo movido pela confiança. E essa confiança só se mantém quando a inovação caminha de mãos dadas com a integridade.

_____

(*) Fundada em 2000, a Zeppelini Publishers atua no segmento editorial técnico e científico, atendendo empresas e organizações e desenvolvendo estratégias para todas as áreas da produção de publicações impressas e online.

Foto: DC Studio / Freepik